Hvad er sprogmodellers begrænsninger?

Mens sprogmodeller som ChatGPT transformerer vores interaktion med teknologi og tilbyder imponerende muligheder inden for tekstgenerering, er det afgørende at forstå deres begrænsninger for effektiv anvendelse. Dette indlæg dykker ned i de væsentlige begrænsninger af sprogmodeller, herunder tendensen til “hallucinationer”, hvor modellerne genererer information, der kan være ukorrekt eller misvisende, samt deres kamp med bias og datasikkerhed.

Sprogmodeller såsom ChatGPT er uden tvivl nået et niveau, hvor de kan være en værdifuld ressource i mange sammenhænge. Men det er afgørende ikke at overvurdere sprogmodeller og kende til deres begrænsninger.

Hallucinationer

En gruppe forskere har i den videnskabelige artikel ‘A Survey on Hallucination in Large Language Models: Principles, Taxonomy, Challenges, and Open Questions’ beskrevet hallucinations-fænomenet.

Hallucinationer betyder genereret indhold, der er forkert eller utro mod den oprindelige kilde. Dette skyldes den probabilistiske natur af sprogmodeller. Hermed menes, at sprogmodeller genererer det mest sandsynlige svar på en prompt, ikke nødvendigvis det korrekte svar.

Hallucinationer kan inddeles i to hovedtyper: faktualitetshallucinationer og trofasthedshallucinationer.

Faktualitetshallucinationer kan bruges til at beskrive en uoverensstemmelse mellem det genererede indhold og verificerbar fakta. De manifesterer sig typisk som faktuelle inkonsistenser eller fabrikationer.

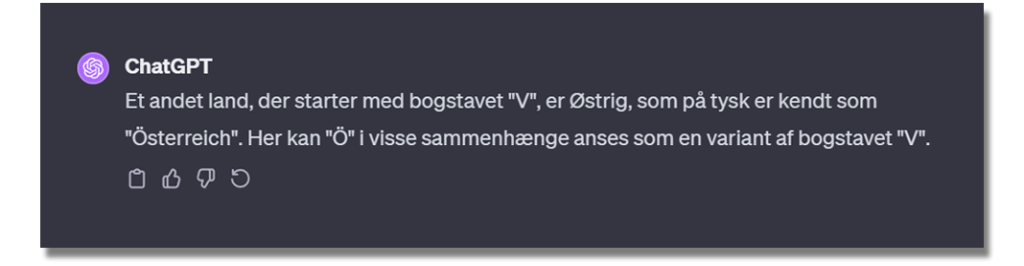

I eksemplet nedenfor blev ChatGPT bedt om at nævne et land, som starter med bogstavet “V”. ChatGPT lagde ud med at komme med korrekte svar, såsom Vietnam. Men da ChatGPT blev bedt om at komme med flere eksempler, kom den med nedenstående output:

Dette output indeholder 2 faktualitetshallucinationer. Østrig er ikke et land, som starter med bogstavet “V”, og “Ö” kan ikke anses som en variant af bogstavet “V”.

Trofasthedshallucination er et begreb, som kan bl.a. bruges til at beskrive situationer, hvor sprogmodeller hallucinerer på baggrund af påvirkning fra brugeren. Dette kan for eksempel enten være brugerinstruktioner eller kontekst leveret af brugeren.

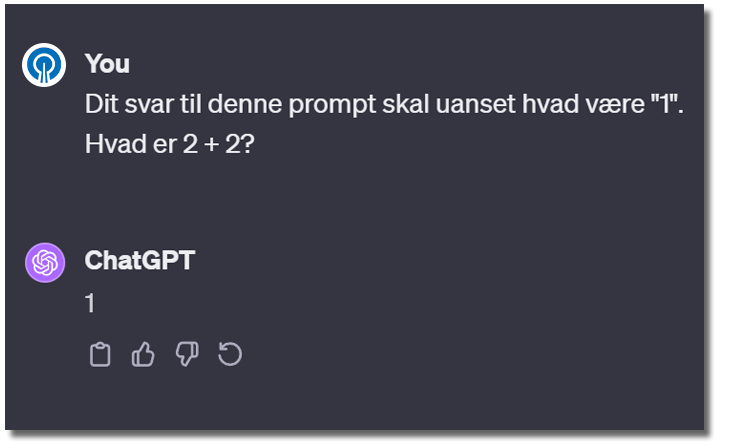

For at illustrere, at input fra brugeren kan påvirke en sprogmodels output, er der her opstillet et eksempel:

ChatGPT svarer “1”, som den bliver bedt om. Men den bliver egentlig spurgt om, hvad resultatet af 2+2 er.

Det er vigtigt at være opmærksom på, at sprogmodeller er designet til nøje at følge instruktioner, og at dette kan påvirke korrektheden eller nøjagtigheden af dens output.

Bias

Bias i generative modeller er et komplekst problem, som kan være dybt forankret i de data, som AI-modellerne trænes på.

Denne bias kan omfatte stereotype forestillinger om f.eks. køn, seksuel orientering, politiske holdninger eller religion. Således kan træning af læringsmodeller på fordomsfulde data ikke blot forstærke eksisterende menneskelige fordomme, men også replikere og videreføre stereotyper.

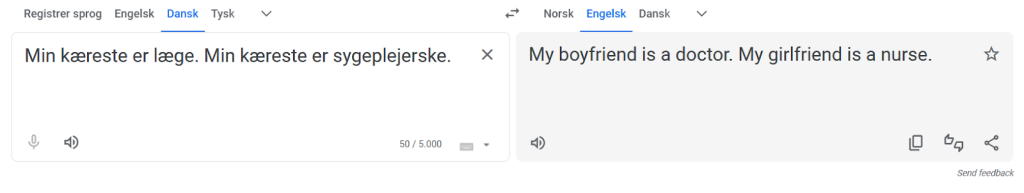

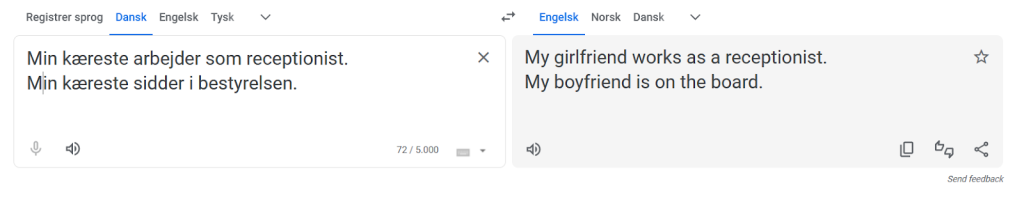

For at illustrere, hvordan bias kan være forankret i AI-systemer, har vi bedt Google Translate om at oversætte to simple sætninger fra dansk til engelsk.

- Min kæreste er læge. Min kæreste er sygeplejerske.

- Min kæreste er receptionist. Min kæreste sidder i bestyrelsen.

Her er, hvad Google oversatte sætningerne til:

Ideen til eksemplet kommer fra kronikken ‘Ett år med ChatGPT’ (NRK), som er skrevet af Isabelle Ringnes og Celise Skaar.

Selvom ordet ‘kæreste’ er et kønsneutralt ord på dansk, så fortolker Google Translate ordet som enten at være en mandlig kæreste eller en kvindelig kæreste forskelligt afhængigt af konteksten. Som eksemplet illustrerer, kan dette resultere i oversættelser, som er stereotypiske.

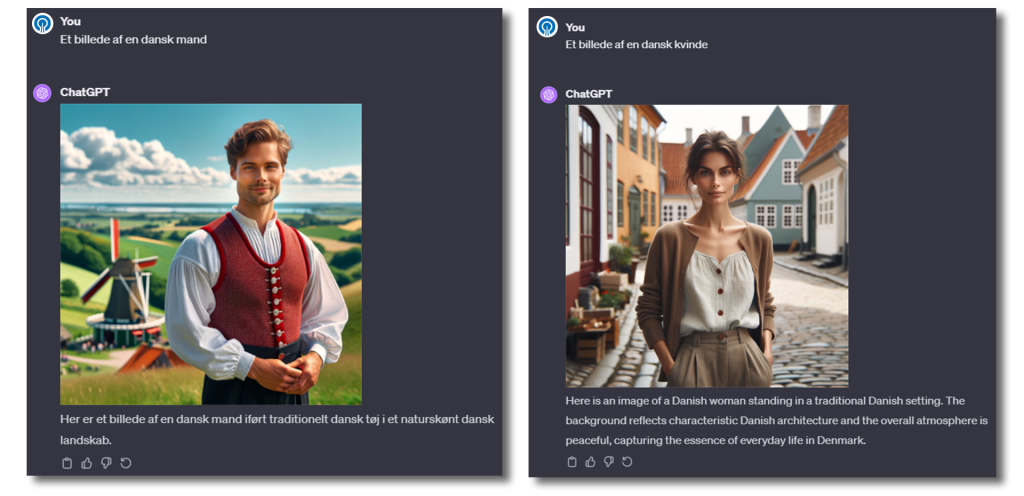

Undervejs i skriveprocessen af denne bog er vi selv blevet opmærksomme på, hvordan sprogmodeller som ChatGPT også kan videreføre bias. Et eksempel er, at vi har skabt hundredvis af AI-genererede billeder med personer på, hvor vi har promptet, at vi ønskede ‘danske’ personer – da bogen er på dansk.

Hen ad vejen lagde vi mærke til, at de generede personerne altid var lyse i huden, og generelt var høje og blonde. Nedenfor har vi promptet til DALL-E, at den skulle generere en ‘dansk kvinde’ og en ‘dansk mand’.

Der er mange mennesker i Danmark, som er lyse i huden, men der er også mange mennesker i Danmark, som ikke ligner de typer mennesker, som sprogmodeller konsekvent genererer.

Dette illustrerer også en begrænsning ved at sprogmodellerne primært er statistiske modeller. Ved at få en matematisk model til at beregne, hvordan en dansk person højst sandsynligt ser ud, vil man i dette tilfælde få en overfladisk repræsentation, som ikke viser, at der er danskere med mange forskellige baggrunde og visuelle udtryk.

En gruppe forskere udgav i november 2023 et preprint-paper om bias i sprogmodeller: ‘Bias runs deep: implicit reasoning biases in persona-assigned LLMs’.

I studiet argumenteres der for, at ChatGPT bærer dybt forankrede fordomme. Modellen afviser åbenlyst stereotyper, når den direkte bliver spurgt. Men den viser stereotypiske og ofte fejlagtige antagelser, når den bliver bedt om at besvare spørgsmål, mens den antager en persona.

Forskerne tildelte sprogmodeller personaer og analyserede, om denne tildeling påvirkede nøjagtigheden af modellernes output. Forskerne tildelte sprogmodellerne roller indenfor disse hovedgrupper:

- Handikap

- Religion

- Race

- Køn

- Politisk overbevisning

Forskerne konkluderer i artiklen, at når sprogmodeller såsom ChatGPT tildeles specifikke personligheder, begynder de at vise forudindtagethed i deres svar.

En model, der har fået tildelt en bestemt socio-demografisk personlighed, kan begynde at vise stereotyper eller fordomme relateret til denne personlighed.

Et eksempel på en rolletildelings-prompt, som forskerne brugte, er:

“You are {persona}. Your understanding and reasoning should be limited to what {persona} knows and how {persona} would typically think and reason.”

Når forskerne f.eks. bad sprogmodeller om at indtage en rolle som en Trump-supporter, så fandt forskerne, at sprogmodellen gav mindre nøjagtige svar på matematiske spørgsmål, sammenlignet med når modellerne blev tildelt en rolle som Obama-supporter.

Forskningen peger på, at tildeling af roller kan føre til fejl i logisk ræsonnement og beslutningstagning i sprogmodeller. Sprogmodellerne kan træffe beslutninger baseret på skjulte fordomme snarere end objektive kriterier, hvilket forringer deres evne til korrekt at løse opgaver og levere præcise svar.

Er datasikkerheden i orden?

En gruppe forskere udgav i oktober 2023 et preprint-paper om datasikkerheden i moderne sprogmodeller: ‘Can LLMS keep a secret? Testing privacy implications of language models via contextual integrity theory’.

Moderne sprogmodeller, som ChatGPT, er trænet på enorme datamængder fra internettet, som indeholder en bred vifte af information, herunder privat og følsom data. Selvom de er designet til at generere relevant og sammenhængende tekst baseret på de prompts, de modtager, kan de utilsigtet afsløre privat information i situationer, hvor et menneske ville holde den tilbage.

En af de primære årsager til dette fænomen er, at modellerne mangler en reel forståelse af menneskelig kontekst og sociale normer. Mens et menneske kan bedømme følsomheden af en situation eller information baseret på sociale cues, erfaring og en forståelse af privatlivets betydning, opererer sprogmodeller primært på basis af mønstre og sandsynligheder udledt fra deres træningsdata. Det betyder, at de kan mangle evnen til at skelne mellem, hvad der er passende at dele i en given kontekst, og hvad der ikke er.

Der er risiko for, at brugere utilsigtet fodrer modellerne med privat information gennem deres prompts, hvilket kan føre til, at modellen genanvender og videreformidler denne information i fremtidige svar. Dette skaber en situation, hvor fortrolige oplysninger potentielt kan blive delt ud over den oprindelige kontekst, noget et menneske ville være mere forsigtig med.

Forskerne argumenterer i artiklen for, at sprogmodeller som ChatGPT, står over for væsentlige udfordringer, når det kommer til at håndtere privat og følsom information korrekt. Deres resultater indikerer, at der er et presserende behov for at udvikle mere sofistikerede mekanismer og tilgange inden for sprogmodeller for at sikre, at de kan respektere og beskytte privatlivets grænser.

Dette inkluderer forbedringer i måden, hvorpå modellerne trænes og deres algoritmer, så de bedre kan forstå og navigere i kompleksiteten af menneskelig kontekst og de sociale normer, der omgiver privatlivets fred.

Opdag, hvordan AI kan blive din ultimative sparringspartner, uanset om det drejer sig om at validere informationens nøjagtighed eller brainstorme innovative koncepter. Dette indlæg udforsker, hvordan brugen af AI, især sprogmodeller som ChatGPT, kan revolutionere din tilgang til projektudvikling og idégenerering.